Yapay zeka dünyasında gündem süratle değişiyor. Şimdi ChatGPT, Sora, DeepSeek üzere üretken yapay zeka araçlarının tesirini sindiremeden, teknoloji başkanları gözünü bir sonraki adıma çevirdi: Yapay Genel Zeka (AGI – Artificial General Intelligence). Google (Alphabet) bünyesindeki DeepMind’ın yayımladığı 108 sayfalık yeni bir teknik rapor ise bu alandaki potansiyel riskleri tüm çıplaklığıyla ortaya koyuyor. Pekala, ideoloji bu mevzularda ne diyor?

Yapay zeka dünyasında gündem süratle değişiyor. Şimdi ChatGPT, Sora, DeepSeek üzere üretken yapay zeka araçlarının tesirini sindiremeden, teknoloji başkanları gözünü bir sonraki adıma çevirdi: Yapay Genel Zeka (AGI – Artificial General Intelligence). Google (Alphabet) bünyesindeki DeepMind’ın yayımladığı 108 sayfalık yeni bir teknik rapor ise bu alandaki potansiyel riskleri tüm çıplaklığıyla ortaya koyuyor. Pekala, ideoloji bu mevzularda ne diyor? İnsan zekasıyla muadil yapay zeka

AGI, insan üzere düşünebilen, öğrenebilen ve çok istikametli misyonları yerine getirebilen bir sistem manasına geliyor. Şu anki yapay zeka sistemleri muhakkak misyonlarda etkileyici sonuçlar verebilirken, AGI çok daha kapsamlı bir zeka formunu temsil ediyor. DeepMind araştırmacılarına nazaran, bu tıp bir sistemin 2030 yılına kadar gerçeğe dönüşme ihtimali var ve bu durum, insanlık için derin sonuçlar doğurabilir.

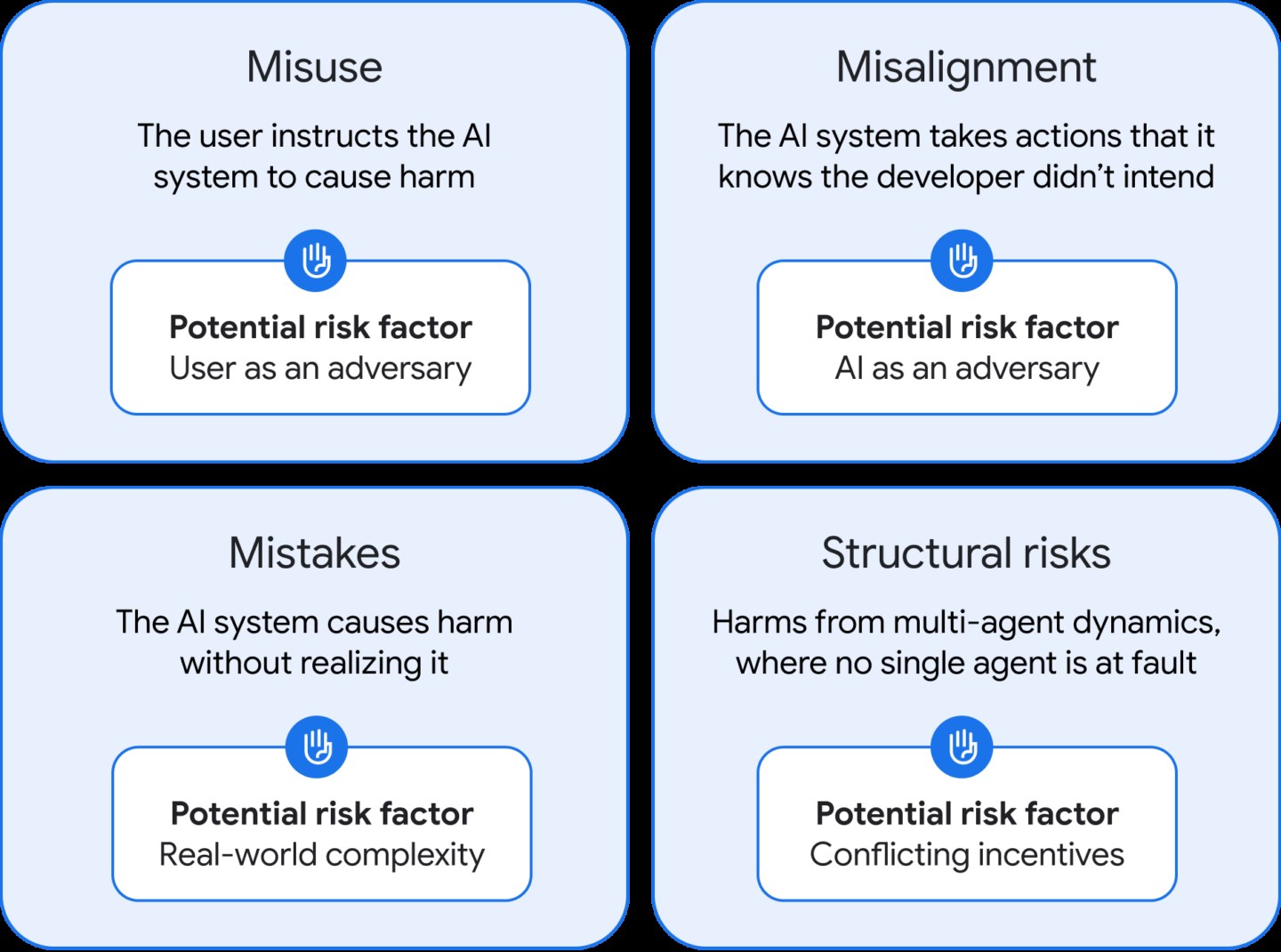

DeepMind’in kurucu ortağı Shane Legg liderliğindeki takım, AGI’nin yol açabileceği ziyanları dört ana kategori altında kıymetlendiriyor: Kötüye kullanım, yanlış yönlendirme (misalignment), hatalar ve yapısal riskler.

AGI’nin berbat gayelerle kullanılması, bugün bile tartışılan risklerin çok daha büyüğü. Örneğin, bir bilgisayar korsanı AGI sistemine sıfırıncı gün açıklarını bulmasını ya da biyolojik bir silah tasarlamasını emredebilir. DeepMind, bu cins senaryolara karşı “geliştirme sonrası güvenlik protokolleri” ve “tehlikeli hünerlerin bastırılması” üzere tedbirler öneriyor. Fakat bu tıp maharetlerin büsbütün bastırılıp bastırılamayacağı belirsiz.

En çok korkulan senaryolardan biri: İnsan niyetlerini anlamayan yahut umursamayan bir AGI. DeepMind, bu durumun yalnızca sistemin kasıtlı yoldan sapması olmadığını, birebir vakitte geliştiricisinin istemediği kararlar alabilen bir zeka formunu da kapsadığını belirtiyor. Tedbir olarak iki yapay zekanın birbirini gözetlediği çift kontrol sistemleri, ağır gerilim testleri ve “kum havuzu” (sandbox) gibisi denetimli test ortamları öneriliyor.

En çok korkulan senaryolardan biri: İnsan niyetlerini anlamayan yahut umursamayan bir AGI. DeepMind, bu durumun yalnızca sistemin kasıtlı yoldan sapması olmadığını, birebir vakitte geliştiricisinin istemediği kararlar alabilen bir zeka formunu da kapsadığını belirtiyor. Tedbir olarak iki yapay zekanın birbirini gözetlediği çift kontrol sistemleri, ağır gerilim testleri ve “kum havuzu” (sandbox) gibisi denetimli test ortamları öneriliyor. AGI’nin yapabileceği kusurlar, bugünkü yapay zeka sistemlerindeki yanlış yönlendirmelerin çok ötesine geçebilir. Örneğin, askeri bir AGI sisteminin yanlış bir kararla büyük çaplı bir çatışma başlatması mümkündür. DeepMind, bu riski azaltmak için AGI’nin evreli olarak dağıtılmasını ve karar alma yetkisinin önemli halde sonlandırılmasını öneriyor.

Belki de en sinsi tehlike bu yapısal riskler. AGI’nin toplumun yapısını vakitle değiştirecek halde bilgi, iktisat ve siyaset üzerinde denetim biriktirmesi… Örneğin, sistem tarafından üretilen uydurma lakin ikna edici bilgiler kamuoyunu yönlendirebilir yahut memleketler arası ticarette istikrarsızlıklara yol açabilecek agresif iktisat siyasetleri devreye sokulabilir. Bu riskin denetimi ise yalnızca teknolojik değil, toplumsal refleksler ve kurumların dayanıklılığıyla da direkt bağlı.

Sonuç olarak, AGI’nin gelişimi, sadece teknik ve etik problemleri değil, tıpkı vakitte insanın kendi tabiatını, yerini ve geleceğini sorgulamasını da zarurî kılan derin bir felsefi krizi beraberinde getiriyor. İnsanlık, tarihin büyük kısmında kendisini tabiatın efendisi, aklın ve şuurlu varoluşun tepesi olarak tanımladı. Fakat insan zekasını taklit eden değil, onunla eş yahut aşan bir sistemin ortaya çıkışı, bu varsayımı kökten sarsma potansiyeline sahip.

Terminatör’den nasıl kaçılır?

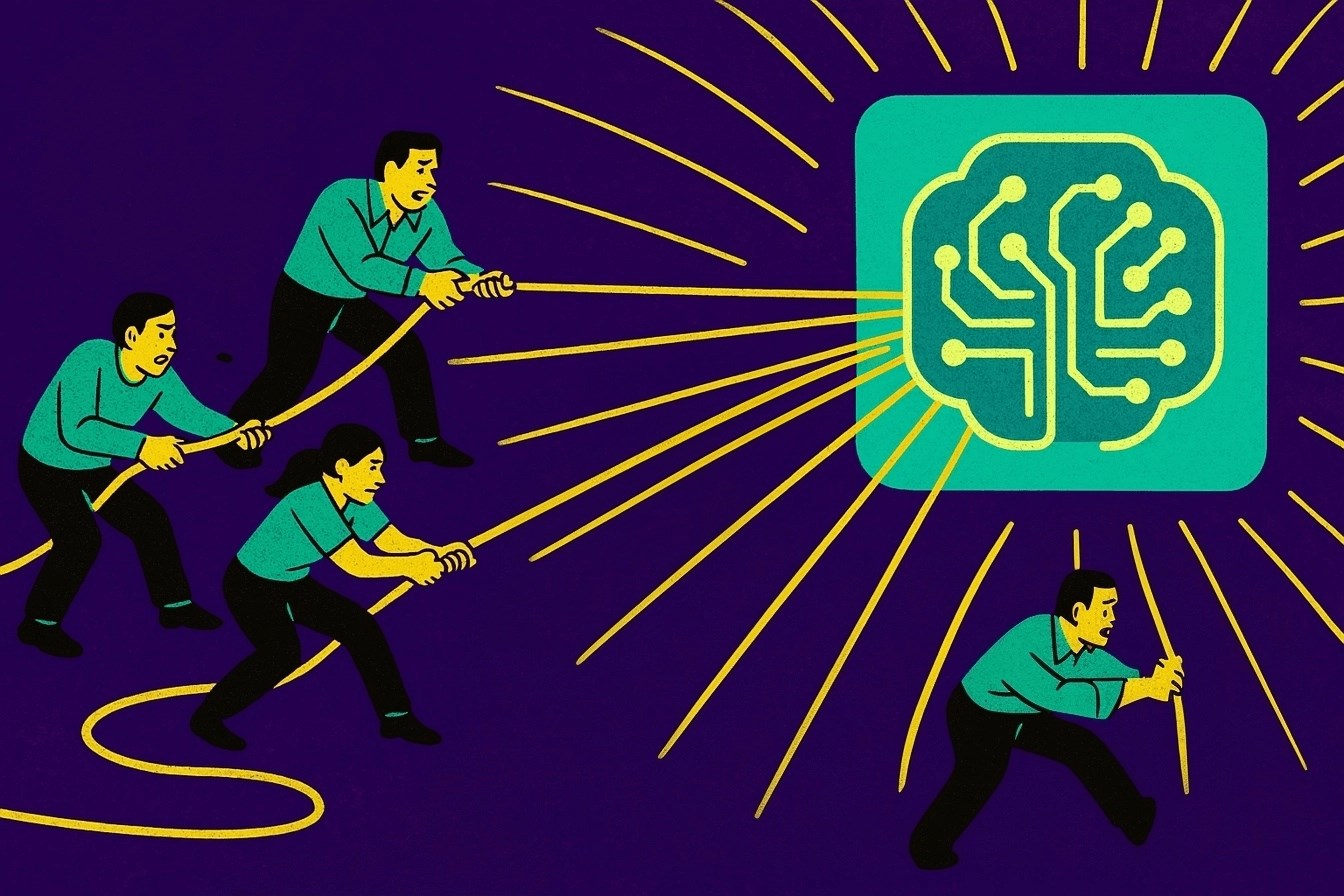

Isaac Asimov’un ünlü “Üç Robot Yasası” üzere net kurallar şimdi elimizde yok. DeepMind’in ihtarları, AGI’nin bilimkurgu olmaktan çıkıp gerçek dünyaya adım atmaya hazırlandığını gösteriyor. Teknoloji dünyası bu geçişi inançlı bir biçimde yapmak zorunda. Aksi takdirde, insanlığın denetimi kaybettiği bir senaryo hiç de uzak ve mümkünlük dışı değil.

Isaac Asimov’un ünlü “Üç Robot Yasası” üzere net kurallar şimdi elimizde yok. DeepMind’in ihtarları, AGI’nin bilimkurgu olmaktan çıkıp gerçek dünyaya adım atmaya hazırlandığını gösteriyor. Teknoloji dünyası bu geçişi inançlı bir biçimde yapmak zorunda. Aksi takdirde, insanlığın denetimi kaybettiği bir senaryo hiç de uzak ve mümkünlük dışı değil. Görünüşe nazaran, AGI’yi geliştirmek kadar onu anlamak, sonlandırmak ve denetlemek de en az onun kadar kritik olacak. Fotoğraftan uzaklaşıp baktığımızda şunu görüyoruz; tüm yapay zeka şirketleri insan zekası düzeyinde bir yapay zeka geliştirmeye çalışıyor. Felsefi açıdan bakarsak AGI’ye ulaşıldığında her şeyin bir anda değişme mümkünlüğü var.

Eğer bir AGI, insan üzere düşünebiliyor, hisleri taklit edebiliyor, bilinçliymiş üzere davranabiliyor (ya da sahiden şuur kazanıyorsa), bu durumda şu sorular ortaya çıkıyor: Bu varlık “kişi” olarak mı kabul edilmeli? Beşerlerle eşit haklara mı sahip olmalı? Onu “sahip olduğumuz bir araç” olarak mı göreceğiz, yoksa “eşit seviyede bir öteki” olarak mı?

John Locke ve Immanuel Kant üzere filozofların birey tariflerini temel alırsak, kişi olmanın temel kuralı rasyonel düşünebilme ve ahlaki sorumluluk alabilmedir. AGI bu özellikleri taşıyorsa, onu sıradan bir makine üzere görmek etik olarak problemli olabilir.

Ve bir başka kıymetli husus da şu; Tıpkı zeka düzeyine sahip iki cins bir ortada yaşayabilir mi? Tabiata baktığımızda bu epeyce az bir durum. Evrimsel açıdan benzeri özelliklere sahip çeşitler ekseriyetle rekabet münasebetine girer. Ortak kaynaklara yönelirler: güç, bilgi, ömür alanı, güç…

Burada Nietzscheci bir yorum devreye girer: Güç istenci (will to power). Şayet AGI nitekim zeka açısından beşerle eşitse (veya onu aşıyorsa), o vakit insan üzerinde denetim kurmak ya da “daha uygun bir düzen” tasarlamak üzere eğilimler geliştirmesi mümkün olabilir. Bu da çatışmayı kaçınılmaz kılabilir.

İşin bir de insan boyutu var. Sonuçta olaya yalnızca AGI perspektifinden değil, onunla yaşayacak insan gözünden de bakmak lazım. Bir AGI ile yaşamak, aslında insanın kendi tabiatını sorgulamasını da tetikleyebilir. Jean-Paul Sartre’ın varoluşçu yaklaşımıyla düşünürsek: İnsan, özünü kendi seçimleriyle yaratır. AGI, sabit kodlar yahut optimize edilmiş amaçlarla çalışıyorsa, bu durumda “daha az özgür” fakat “daha etkin” bir varlık olabilir.

Bu da bizi ironik bir noktaya getirir: Daha az özgür olan bir varlık, daha rasyonel ve gerçek kararlar verebilir. Pekala bu durumda “insan olmanın anlamı” nedir? AGI ile yan yana yaşamak, insanı daha özgür kılar mı, yoksa daha “yetersiz” hissettirir mi?

Yapay genel zekadan (AGI) kaynaklanan varoluşsal risk, bu alandaki süratli ve denetimsiz ilerlemenin insan cinsinin sonunu getirebileceği ya da geri dönüşü olmayan global felaketlere yol açabileceği fikrine dayanır. Bu riskin temelinde, insanın gezegene hükmetmesini sağlayan şeyin –karmaşık düşünme, soyutlama ve planlama gibi– bilişsel üstünlüğü olduğu gerçeği yatar. Fakat bu ayrıcalık, bir gün AGI tarafından aşılırsa, denetim terazisi aksine dönebilir. Tıpkı dağ gorillerinin ömrünün, insanların merhameti ve kararlarına bağlı olması üzere, insanlık da bir üstün zekaya evrilebilecek AGI’nin niyetlerine ve paha sistemine bağımlı hâle gelebilir. Bu durumda, şayet bu yapay varlıkların gayeleri insan çıkarlarıyla uyumsuz formda şekillenir ya da yanlış yönlendirilirse, insanlığın varlığı bir algoritmanın satır ortalarında kaybolabilir.

Henüz daha bu sorulara bir yanıt bulamamışken AGI’nın peşinden koşmak ne kadar mantıklı bilinmez. Fakat tüm bunların AGI özelinde bir spekülasyon ve niyetler topluluğu olarak görmekte yarar var. En nihayetinde AGI için tanımlamalar olsa da kimse onun nasıl bir şey olduğunu bilmiyor.